你第几天了?我病倒了骑行50公里来到玉门市,入住

在线urlencode/urldecode编码,支持utf8/gb2312中文解码及编码。. 方法/步骤 1/7 分步阅读 这是微博搜索“我爱你”的页面及其url代码,可以看到“我爱你”被转码成了“%25e6%2588%2591%25e7%2588%25b1%25e4%25bd%25a0” 2/7.

本文深入探讨了url编码与解码原理,特别是url二次编码的特殊情况。 通过实例演示了如何在javascript中使用decodeuri ()正确处理二次编码,揭示了二次编码的内部机制。 今天遇到了一个奇怪的问题:在js中用decodeuri ()解析完一串url编码后发现它依旧是url编码,看的我一脸懵逼! 最后发现参数里面竟然是一个url二次编码! 类似下面这种形式: url编码原理:这个百度百科上解释的就很好:url编码就是一个字符ascii码的 十六进制。 不过稍微有些变动,需要在前面加上“%”。 比如:“\”,它的ascii码是92,92的十六进制是5c,所以“\”的url编码就是%5c。. 如果某个参数是一个网址,这个网址中包含 & = 等符号,就会影响解析,解决方案就是服务端将 一个url 中的网页地址参数 用urlencode编码一下. 可使用这个在线工具验证 链接. string scheme = uri.getscheme(); string url = uri.getqueryparameter("url");. 本文提供了一个使用javascript进行uri解码的简单示例。 通过双重解码操作,可以将编码后的字符串转换回原始格式。 先对一“xxx”字符串进行第一次url编码:得到结果(一): 结果(一): % e 5% 88 % 9b % e4 % b8 % 9a % e4 %bc% 9e % e6 % 8a % 9 5% e8 % b 5% 84 % e6 % 9c % 89 % e9 % 99 % 90 % e 5% 8 5% ac % e 5% 8f % b8 再对结果(一)进行二次编码:得到结果(二): %25 e 5%25 88 %25 9b %25 e4 %25 b8 %25 9a %25 e4 %25bc%25 9e %25 e6 %25 8. U 0000 u 10ffff: no block u 0000 u 007f: basic latin u 0080 u 00ff: latin 1 supplement u 0100 u 017f: latin extended a u 0180 u 024f: latin extended b u 0250 u 02af: ipa extensions u 02b0 u 02ff: spacing modifier letters u 0300 u 036f: combining diacritical marks u 0370 u 03ff: greek and coptic u 0400.

本文提供了一个使用javascript进行uri解码的简单示例。 通过双重解码操作,可以将编码后的字符串转换回原始格式。 先对一“xxx”字符串进行第一次url编码:得到结果(一): 结果(一): % e 5% 88 % 9b % e4 % b8 % 9a % e4 %bc% 9e % e6 % 8a % 9 5% e8 % b 5% 84 % e6 % 9c % 89 % e9 % 99 % 90 % e 5% 8 5% ac % e 5% 8f % b8 再对结果(一)进行二次编码:得到结果(二): %25 e 5%25 88 %25 9b %25 e4 %25 b8 %25 9a %25 e4 %25bc%25 9e %25 e6 %25 8. U 0000 u 10ffff: no block u 0000 u 007f: basic latin u 0080 u 00ff: latin 1 supplement u 0100 u 017f: latin extended a u 0180 u 024f: latin extended b u 0250 u 02af: ipa extensions u 02b0 u 02ff: spacing modifier letters u 0300 u 036f: combining diacritical marks u 0370 u 03ff: greek and coptic u 0400. 这是经过二次编码的url编码,其中%25是经过二次编码的结果,其原形就是百分号,所以经一次解码后应为 %e4%ba%b2%e5%ad%90 然后就能看出这. Well organized and easy to understand web building tutorials with lots of examples of how to use html, css, javascript, sql, python, php, bootstrap, java, xml and more. 关系型数据库:mysql、oracle等,保存数据量大。 非关系型数据库:mongodb、redis等键值对形式存储数据,保存数据量大。 二进制文件:保存爬取的图片、视频、音频等格式数据。 首先,爬取豆瓣读书《平凡的世界》的1页短评信息,然后保存到文件中。 book.douban.com/subject/120… from lxml import etree. "user agent": "mozilla/5.0 (macintosh; intel mac os x 10 15 7) applewebkit/537.36 (khtml, like gecko) chrome/87.0.4280.88 safari/537.36" . 本文介绍了一种特殊的网站url编码方式,该方式采用了双重编码处理:先使用'utf 8'编码,再进行'gb2312'编码。 通过python代码示例展示了如何构建正确的url以用于爬虫抓取。 search后面跟着那么长一串,让人摸不着头脑。 爬取网站信息的第一步就是,根据关键词,构建出包含着”爬取意图“的url,也就是把key的值加进去。 很多常规的是对中文关键词进行’utf 8’或‘gb2312’编码即可。 各种尝试了一通,发现这是进行了双重编码处理的,从每个%后面都跟着25便可发现端倪。 最后,终于被我发现了,这是先用’utf 8’编码,再套了一层’gb2312’… 输出结果: 问题解决! 文章浏览阅读5.1k次,点赞2次,收藏3次。.

这是经过二次编码的url编码,其中%25是经过二次编码的结果,其原形就是百分号,所以经一次解码后应为 %e4%ba%b2%e5%ad%90 然后就能看出这. Well organized and easy to understand web building tutorials with lots of examples of how to use html, css, javascript, sql, python, php, bootstrap, java, xml and more. 关系型数据库:mysql、oracle等,保存数据量大。 非关系型数据库:mongodb、redis等键值对形式存储数据,保存数据量大。 二进制文件:保存爬取的图片、视频、音频等格式数据。 首先,爬取豆瓣读书《平凡的世界》的1页短评信息,然后保存到文件中。 book.douban.com/subject/120… from lxml import etree. "user agent": "mozilla/5.0 (macintosh; intel mac os x 10 15 7) applewebkit/537.36 (khtml, like gecko) chrome/87.0.4280.88 safari/537.36" . 本文介绍了一种特殊的网站url编码方式,该方式采用了双重编码处理:先使用'utf 8'编码,再进行'gb2312'编码。 通过python代码示例展示了如何构建正确的url以用于爬虫抓取。 search后面跟着那么长一串,让人摸不着头脑。 爬取网站信息的第一步就是,根据关键词,构建出包含着”爬取意图“的url,也就是把key的值加进去。 很多常规的是对中文关键词进行’utf 8’或‘gb2312’编码即可。 各种尝试了一通,发现这是进行了双重编码处理的,从每个%后面都跟着25便可发现端倪。 最后,终于被我发现了,这是先用’utf 8’编码,再套了一层’gb2312’… 输出结果: 问题解决! 文章浏览阅读5.1k次,点赞2次,收藏3次。.

关系型数据库:mysql、oracle等,保存数据量大。 非关系型数据库:mongodb、redis等键值对形式存储数据,保存数据量大。 二进制文件:保存爬取的图片、视频、音频等格式数据。 首先,爬取豆瓣读书《平凡的世界》的1页短评信息,然后保存到文件中。 book.douban.com/subject/120… from lxml import etree. "user agent": "mozilla/5.0 (macintosh; intel mac os x 10 15 7) applewebkit/537.36 (khtml, like gecko) chrome/87.0.4280.88 safari/537.36" . 本文介绍了一种特殊的网站url编码方式,该方式采用了双重编码处理:先使用'utf 8'编码,再进行'gb2312'编码。 通过python代码示例展示了如何构建正确的url以用于爬虫抓取。 search后面跟着那么长一串,让人摸不着头脑。 爬取网站信息的第一步就是,根据关键词,构建出包含着”爬取意图“的url,也就是把key的值加进去。 很多常规的是对中文关键词进行’utf 8’或‘gb2312’编码即可。 各种尝试了一通,发现这是进行了双重编码处理的,从每个%后面都跟着25便可发现端倪。 最后,终于被我发现了,这是先用’utf 8’编码,再套了一层’gb2312’… 输出结果: 问题解决! 文章浏览阅读5.1k次,点赞2次,收藏3次。.

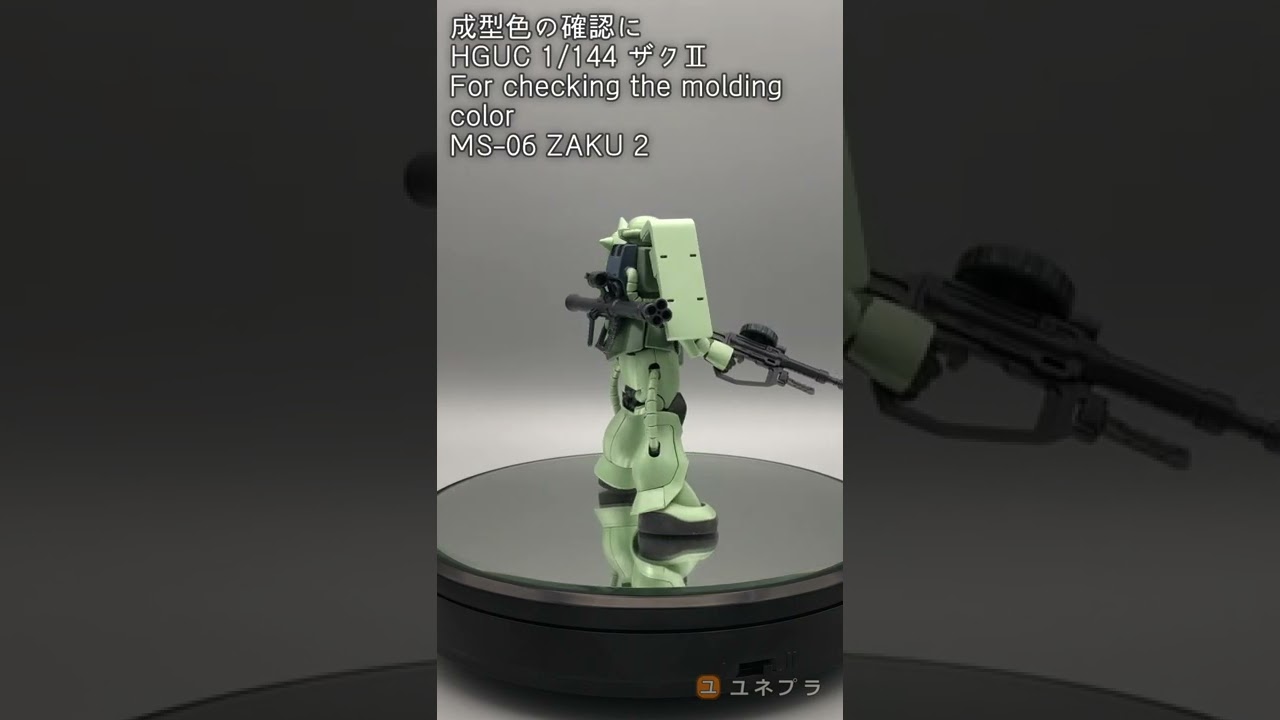

【ガンプラ #Shorts 】成型色の確認に HGUC 1/144 ザクⅡ For checking the molding color MS-06 ZAKU 2 01

【ガンプラ #Shorts 】成型色の確認に HGUC 1/144 ザクⅡ For checking the molding color MS-06 ZAKU 2 01

Related image with 你第几天了?我病倒了骑行50公里来到玉门市,入住

Related image with 你第几天了?我病倒了骑行50公里来到玉门市,入住

About "你第几天了?我病倒了骑行50公里来到玉门市,入住"

![一分鐘新聞 (香港版) [2024-05-24 (五)] 一分鐘新聞 (香港版) [2024-05-24 (五)]](https://i0.wp.com/ytimg.googleusercontent.com/vi/VtZoI30AAa0/mqdefault.jpg?resize=91,91)

![一分鐘新聞 (香港版) [2024-11-30 (六)] 一分鐘新聞 (香港版) [2024-11-30 (六)]](https://i0.wp.com/ytimg.googleusercontent.com/vi/1M8hM4Wyt5o/mqdefault.jpg?resize=91,91)

Comments are closed.